“El diabólico radicalismo islámico”, por Beatriz Rittigstein

29 agosto, 2024

Organizaciones terroristas en Gaza estarían planeando un golpe contra Sinwar

1 septiembre, 2024Israel/Diáspora

Startup israelí desarrolló detector de mentiras para el mundo deepfake de hoy

El software Illuminator de Revealense reconoce indicadores que ayudan a las empresas a saber si un cliente está diciendo la verdad, y determinar si un video ha sido generado por inteligencia artificial

John Jeffay*

Me sorprendí por la ansiedad que sentí en los momentos previos a mi “prueba de la verdad”. Estaba a punto de responder una docena de preguntas que evaluarían mi honestidad e integridad.

No se trata de un cuestionario escrito, con respuestas correctas e incorrectas. Es una aplicación de inteligencia artificial que me observa, escucha y evalúa en función de indicadores sobre los que no tengo control, como cambios en la pigmentación de la piel, flujo sanguíneo, pulso, voz, parpadeo de los ojos, expresiones faciales y signos de actividad cerebral.

(Imagen: Revealense)

Tengo que responder cada pregunta en voz alta y marcar la respuesta, en una escala del 1 al 7, indicando cuán de acuerdo o en desacuerdo estoy con cada afirmación. Lo que importa, más que las respuestas en sí, son los niveles de estrés, cognición y emoción que la IA detecta, a través de un enlace de video estándar de una computadora portátil, mientras las respondo. La IA está entrenada para reconocer la disonancia cognitiva, que es la incomodidad que sentimos cuando mantenemos (y verbalizamos) creencias, valores o actitudes conflictivas.

El sistema, desarrollado por la startup israelí Revealense, capta toda una serie de pequeñas pistas, y las interpreta con tal precisión que las compañías de seguros confían en él para comprobar si los solicitantes dicen la verdad sobre lo que les robaron; las empresas financieras lo utilizan para tomar decisiones sobre préstamos; las agencias de seguridad nacional lo usan para identificar amenazas terroristas; los gerentes de recursos humanos lo emplean para ayudar a tomar decisiones sobre quién obtiene el trabajo, y los sicólogos para ayudar a diagnosticar el trastorno de estrés postraumático.

Los casos de Tom Cruise y Bill Clinton

La compañía describe lo que hace como «analizar el ADN del comportamiento humano a través de una IA responsable». Las decisiones que tomamos los seres humanos, basadas en el contacto cara a cara, pueden ser poco fiables porque están influenciadas por nuestra cultura, estado mental y experiencias pasadas. Pero la IA es imparcial y no tiene una agenda. Realiza mediciones precisas y objetivas de los cambios fisiológicos de una persona dentro de un contexto específico, que son demasiado sutiles para que podamos verlos o escucharlos.

Las decisiones que tomamos los seres humanos, basadas en el contacto cara a cara, pueden ser poco fiables porque están influenciadas por nuestra cultura, estado mental y experiencias pasadas. Pero la IA es imparcial y no tiene una agenda

Amit Cohen, director de productos de la empresa, me muestra el software Illuminator en acción con un par de momentos icónicos en vídeo. En el primero, le preguntaron al actor Tom Cruise si Nicole Kidman fue el amor de su vida, después de que su matrimonio de 11 años terminara con su “separación consciente”. “En el momento en que escucha su nombre, vemos que se desencadenan muchas emociones y muchos pensamientos. Se confunde y se pone nervioso”, dice Cohen, después del clip de YouTube de 38 segundos. “No sé si realmente ama a Nicole Kidman o si realmente la odia. Pero lo que sí sé es que cuando le hacen esa pregunta algo explota dentro de él, aunque esté poniendo cara de póquer, sea un actor de cine y sepa cómo actuar frente a la cámara”. A pesar del exterior tranquilo del actor, el software detecta niveles altísimos de estrés, emoción y cognición a partir de las señales involuntarias que emite.

El expresidente estadounidense Bill Clinton obtuvo una puntuación baja en cuanto a falsedad al principio, cuando declaró ante las cámaras en 1998: “No tuve relaciones sexuales con esa mujer”. En cierta medida, estaba siendo sincero. Según una interpretación muy particular de “relaciones sexuales”, se había convencido a sí mismo de que no estaba mintiendo sobre lo que sucedió entre él y Monica Lewinsky. Cohen dice: “En el video vemos que mintió, pero se creyó su propia mentira. Casi los convenció a todos, pero al final del video vemos una explosión en su cognición y emoción. Está tratando de creer en su mentira, pero no puede manipular su biología interna”.

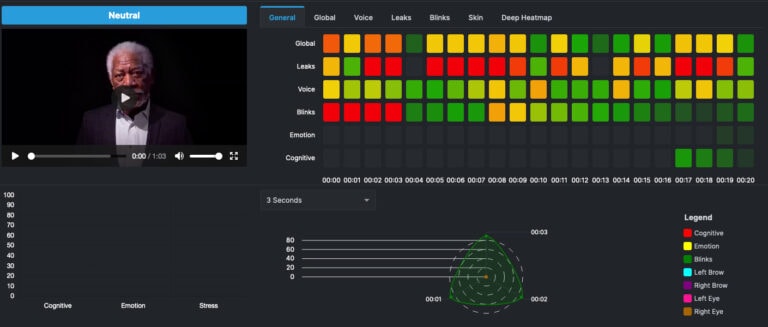

Captura de pantalla del análisis elaborado por el software Illuminator de un video del actor Morgan Freeman

(Foto: Revealense)

El software Illuminator puede proporcionar información útil a partir de tan solo 20 segundos de video de calidad razonable.

Detector de deepfakes

La startup también acaba de presentar una nueva herramienta que utiliza Illuminator para combatir la creciente amenaza de los deepfakes (imágenes o videos falsos, que han sido generados o manipulados de manera convincente) en los procesos electorales, un lanzamiento oportuno teniendo en cuenta las elecciones estadounidenses, entre muchas otras, que se celebrarán en los próximos meses.

El detector analiza los videos a gran escala y los clasifica como deepfakes, auténticos, o sospechosos para examinarlos más a fondo. Puede procesar volúmenes ilimitados de contenido, desde vídeos individuales hasta millones de ellos, lo que lo convierte en un activo inestimable para la integridad electoral.

China utiliza contenido impulsado por IA para influir en las elecciones, como se vio en los comicios de principios de este año de Taiwán y en el período preelectoral de la India, donde una enorme cantidad de llamadas de voz generadas por IA imitaron a figuras públicas

“Con un aumento interanual de los deepfakes del 245% en 2024, el potencial de influir en acontecimientos importantes como las elecciones nacionales es significativo”, dice Dov Donin, fundador y director ejecutivo de la empresa. “Nuestro sistema ya lo utilizan varios gobiernos para proteger los procesos democráticos de las campañas de desinformación”.

Definitivamente se trata de un problema grave, pues los videos falsos pueden moldear fácilmente las actitudes e influir en el comportamiento de los votantes. En enero, una llamada automática que imitaba la voz del presidente Biden aconsejó a los votantes de New Hampshire que se abstuvieran de participar en las primarias demócratas, una táctica destinada a manipular la participación electoral. También en Estados Unidos, la manipulación de figuras políticas mediante deepfakes se ha generalizado, y se utilizan imágenes y vídeos sintéticos para influir en el sentimiento de los votantes. Por ejemplo, se distribuyó una imagen falsa de Trump abrazando a partidarios negros para reforzar su popularidad.

A nivel internacional, se ha informado que China utiliza contenido impulsado por IA para influir en las elecciones, como se vio en los comicios de principios de este año de Taiwán y en el período preelectoral de la India, donde una enorme cantidad de llamadas de voz generadas por IA imitaron a figuras públicas.

(Imagen: Revealense)

“Las tecnologías actuales permiten la creación de videos falsos muy realistas a los que puede acceder cualquier persona en línea, lo que amplifica su impacto a través de las redes sociales, la plataforma más influyente en las democracias por su alcance incomparable”, explica Donin. “Esta situación subraya la urgente necesidad de contar con tecnologías fiables y éticas para la detección de falsificaciones. Estas herramientas son cruciales para que las instituciones y los medios de comunicación ayuden a los ciudadanos del mundo a distinguir entre la realidad y el contenido manipulado, garantizando una navegación más segura e informada en el mundo moderno”.

Las compañías de seguros estadounidenses también están utilizando esta tecnología para acelerar la liquidación de reclamaciones de personas dispuestas a someterse a una prueba de veracidad. Proporcionan detalles de lo que les robaron de su casa a través de un enlace de video, y luego declaran que no han “completado” su reclamación. Illuminator está observando, muy de cerca, en busca de señales de disonancia cognitiva, también conocida como mentira o, en este caso, “fraude leve”.

Es una versión inteligente del antiguo “detector de mentiras” o polígrafo, que se basaba en indicadores físicos: frecuencia respiratoria, transpiración, presión arterial y frecuencia cardíaca. El polígrafo, que ya tiene un siglo de antigüedad, solo se puede utilizar para preguntas de sí o no, y los escépticos lo han descartado como seudocientífico.

“También estamos utilizando nuestra tecnología para identificar la posibilidad de trastorno de estrés postraumático entre los soldados que regresan de la guerra. Ya estamos trabajando con el ejército israelí en una tecnología que pueda evaluar en cuestión de minutos las posibilidades de que un soldado desarrolle un trauma posterior”

Los intentos más recientes de contar con una prueba de la verdad han implicado bombardear a las personas con cientos de preguntas muy similares en rápida sucesión, basándose en la lógica de que darán una respuesta verdadera si no tienen tiempo de pensar en una falsa.

Hay otras empresas que miden algunos aspectos del comportamiento humano involuntario, como el análisis de la voz o los movimientos oculares. “Hasta donde sé, somos la única compañía que ha logrado reunir varios factores humanos en paralelo y luego analizarlos en un panel como el nuestro”, dice Cohen.

Trastorno de estrés postraumático y deepfakes

Revealense fue fundada en 2021 en Petaj Tikva, en el centro de Israel, y ha recaudado más de 4 millones de dólares de financiamiento. “También estamos utilizando nuestra tecnología para identificar la posibilidad de trastorno de estrés postraumático (PTSD por sus siglas en inglés) entre los soldados que regresan de la guerra”, comenta Cohen. “Ya estamos trabajando con el ejército israelí en una tecnología que pueda evaluar en cuestión de minutos las posibilidades de que un soldado desarrolle un trauma posterior”.

El futuro traerá nuevos desafíos en términos de deepfakes, agrega, como el convincente video que apareció hace un par de años que parecía mostrar al actor Morgan Freeman declarando: “No soy Morgan Freeman. Y lo que ves no es real”.

Ya existe la tecnología para producir videos que lucen y suenan exactamente como un presidente, un actor o incluso un miembro de su propia familia, con consecuencias potencialmente devastadoras. Los estafadores pueden crear un deepfake ultrasofisticado de su hijo, por ejemplo, en una videollamada diciendo: «Hola papá, estoy corto de dinero y me quedé sin gasolina. ¿Puedes trasferirme algo?». Pero el deepfake no tendrá los signos reveladores de la verdad que la IA de Revealense está entrenada para detectar y analizar.

*Periodista.

Fuente: israel21c.org.

Traducción Sami Rozenbaum / Nuevo Mundo Israelita.